Funktionsweise des World Wide Web

... [Seminar "Verteilte Systeme"]

... [Inhaltsverzeichnis]

... [weiter] ...

Abschlussbetrachtung

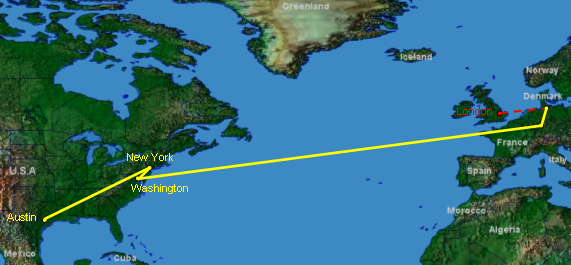

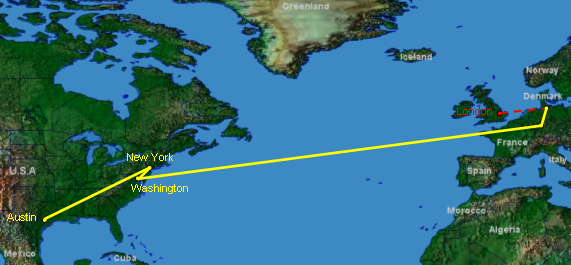

Als Zusammenfassung der vorhergehenden Kapitel soll an dieser Stelle ein

kompletter Seitenabruf einschließlich aller dazu benötigten Techniken erläutert

werden. Dazu möchte ein hamburger Hansenet-Kunde von seinem Rechner aus die

Webseite der öffentlichen Bibliothek in New York http://www.nypl.org/ (New York

Public Library) abrufen. Der in der folgenden Abbildung zu sehende Datenfluss

wurde mit VisualRoute (www.visualroute.com), einer grafischen Umsetzung des

Kommandozeilen-Tools traceroute, mitgeschnitten.

Um die Seite www.nypl.org abzurufen, verbindet sich der Hansenet-Kunde mit dem

POP seines ISP und bekommt von diesem eine IP zugewiesen. Anschließend gibt der

Kunde an seinem Rechner (A) die URL http://www.nypl.org/ in seinen Browser ein,

wodurch er eine DNS-Vorwärtsabfrage an den DNS-Server von Hansenet startet.

Angenommen die IP der gesuchten Bibliotheksseite ist nicht in dessen Cache

vorhanden, so wird die DNS-Abfrage an einen Root-Server, z.B. den Ripe-Server in

London, weitergegeben. Hierarchisch absteigend wird von hier aus die IP der

gesuchten URL ermittelt und das Ergebnis letztendlich über den DNS-Server des

ISP an den Hansenet-Kunden weitergegeben. Ausgerüstet mit der gerade erhaltenen

IP kann Rechner (A) seine Seitenanfrage über das Netz von Hansenet und das

Backbone-Netz zum DE-CIX in Frankfurt schicken.

Von dort wandert sie über ein Unterseekabel rüber nach Washington, wo eine

starke Netzauslastung eine direkte Weitervermittlung nach Austin verhindert. Mit

Hilfe der Routingprotokolle EGP und BGP wird die Anfrage daraufhin über New York

nach Austin auf den Server mit der Seite der NYPL umgeleitet. Über das

Übertragungsprotokoll http und mit dem Anforderungsbefehl GET wird die

Startseite index.html von http://www.nypl.org/ auf den Rechner (A) übertragen

und in dessen Browser angezeigt.

Das World Wide Web wird ohne Frage in den nächsten Jahren weiter wachsen und

neue Nutzungsmöglichkeiten und Dienste hervorbringen. Dabei ist anzunehmen, dass

die bestehenden Konzentrationspunkte wie die vier großen Internetknoten in New

York, Washington, London und Paris sowie das DE-CIX vorerst weiter bestehen

werden. Dies ist momentan auf den harten Wettbewerb zwischen den großen Carriern

zurückzuführen, der auf Kosten der Sicherheit und Redundanz geht.

Auch die geografische Konzentration der 13 Rootserver wird sich wohl nicht so

schnell ändern, da ein Großteil der Rootserver historisch bedingt in den USA

steht. Jedoch bilden sich hier bereits die ersten Alternativen heraus. So gibt

es seit Ende 2002 ein "Open Root Server Network", welches parallel zu den

offiziellen 13 Rootservern zur Namensauflösung verwendet werden kann.

Bei der Vergabe von IP-Adressen sind ebenfalls Neuerungen zu erwarten, hier wird

in den nächsten Jahren die derzeitige IP Version 4 durch die neue Version 6

abgelöst werden, da der Adressraum von IPv4 langsam knapp wird.

Auch bei den Top Level Domains bahnen sich die ersten Engpässe an, weshalb in

den letzten Jahren immer wieder neue wie biz, .info oder .museum von der ICANN

genehmigt wurden.

Netzintern sind ebenfalls Änderungen zu bemerken, so wird weiterhin versucht,

den "Dark Adress Space" zu minimieren und zusätzlich Dokumente über URNs und den

neuen Dienst URS dauerhaft zu adressieren und auffindbar zu machen.

... [Seminar "Verteilte Systeme"]

... [Inhaltsverzeichnis]

... [weiter] ...